È il tema più caldo del momento, e Adobe, da leader nel campo dei software per l'elaborazione di immagini e la produzione di contenuti, non poteva certo ignorare l'IA generativa.

Del resto, Adobe integra strumenti di intelligenza artificiale e machine learning nei suoi prodotti ormai da un decennio (vedi Sensei).

Quella piattaforma si ora evoluta in IA generativa e ha assunto la forma di Firefly, che altro non è se non una famiglia di modelli di IA generativa pensati per dare valore aggiunto ai software esistenti (o a specifiche funzioni di quei software).

Lo strumento è rimasto per diverso tempo in fase beta pubblica, ed è da poco disponibile nella sua forma definitiva all'interno di Photoshop V25.0. Ma partiamo dall'inizio. Chi vuole sperimentare in prima persona le meraviglie dell'IA generativa può partire da firefly.adobe.com (necessario un account Adobe, anche gratuito). Da qui, è al momento possibile esplorare, direttamente online, quattro filoni principali: Da testo a immagine, Riempimento generativo, Effetti di testo e Ricolorazione generativa (per immagini vettoriali).

In alcuni casi si verrà rimandati ad Adobe Express, l'App online tutto-in-uno per content creator, che è in effetti un altro modo per accedere alle funzioni di IA generativa Da testo a immagine ed Effetti di testo. Anche in questo caso, esiste un piano gratuito.

Infine, dall'App Creative Cloud (di nuovo: è sufficiente attivare una prova gratuita), è possibile scaricare una versione di prova di Photoshop (V.25.0) o, selezionando App Beta, scaricare Photoshop (Beta), attualmente alla versione 25.1, che contengono entrambi la funzione Riempimento generativo, prima implementazione pratica dell'IA generativa all'interno di un'applicazione Adobe.

Abbiamo sperimentato le funzioni attualmente disponibili, con particolare attenzione a Photoshop e all'ambito più prettamente fotografico. Per inciso, oltre ad essere quella più "in sintonia" con Fotografi Digitali, la funzione Riempimento generativo è anche quella più matura, già in grado di inserirsi utilmente nel lavoro quotidiano del fotografo o del grafico.

Iniziamo col dire che, con la funzione Riempimento generativo di Photoshop, è possibile rimuovere elementi indesiderati, cambiare formato all'immagine, ad esempio trasformando un formato quadrato in 16:9 e chiedendo all'IA di "inventare" il contenuto inesistente, modificare un elemento esistente, chiedendo all'IA di crearne una variante, o inserire un elemento completamente nuovo, o ancora effettuare sostituzioni di parti anche macroscopiche della scena, come ad esempio sostituire il cielo o inserire uno specchio d'acqua in un'immagine dove si trovava originariamente un prato.

Il funzionamento è davvero semplice. Iniziando dal caso dell'estensione di formato, il punto di partenza è lo strumento Taglierina. Selezionato questo strumento, la barra degli strumenti contestuale attiva immediatamente la funzione Espansione generativa, consentendo di scegliere opzionalmente un formato specifico. Basta trascinare i bordi della taglierina oltre i margini dell'immagini originale e scrivere, opzionalmente, una descrizione testuale del contenuto che si vuole aggiungere, quindi premere Genera.

Dando un input testuale, questo verrà ovviamente seguito e l'oggetto descritto apparirà nella scena. Viceversa, se non si scrive nulla, verrà generata un'immagine coerente con il contenuto originale, senza aggiunte.

Prima

Estensione

Dopo

Per questo strumento, si possono considerare "facili" immagini di paesaggio, per loro natura a pattern irregolare, privi di elementi geometrici da far collimare. Con questo tipo di immagine (vedi esempi), i risultati sono pressoché perfetti, pronti all'uso. La parte di immagine mancante viene generata in assoluta coerenza con tutti gli elementi della scena, creando un risultato credibile e convincente, di fatto indistinguibile dalla scena reale.

Estensione

Dopo

Più rigide sono le geometrie presenti sulla scena, peggiore sarà il risultato ma, per dare la giusta misura di ciò di cui stiamo parlano, mostriamo il risultato di un'estensione "impossibile": modella, capelli lisci mossi dalla macchina del vento, parzialmente tagliati.

Certo, l'estensione non è perfetta, e osservando l'immagine ingrandita si può facilmente notare la linea verticale corrispondente al margine originale. Ciò premesso, si possono fare un paio di considerazioni. Innanzitutto, l'immagine risulta complessivamente credibile, e a uno sguardo distratto (magari in una sua versione web, a bassa risoluzione) appare realistica. In seconda battuta, questi errori "di interfaccia" possono, in alcuni casi, essere corretti con strumenti tradizionali (Timbro clone e simili) o mitigati con sfocature ad hoc.

Possiamo dunque dire che anche immagini estremamente critiche vengono gestite in modo compatibile con un utilizzo professionale.

Da sottolineare, in proposito, come il software proponga sempre tre varianti della porzione generata, tra cui scegliere liberamente, e qualora nessuna di esse risulti soddisfacente, è sempre possibile tentare nuovamente la sorte facendo generare all'IA nuove soluzioni.

Estensione

Dopo

Altrettanto importante ai fini pratici che l'oggetto generato venga creato su un livello separato, facilitandone la gestione e l'integrazione nella scena originale grazie anche ai tradizionali metodi di fusione. Insomma: intorno all'IA generativa c'è sempre Photoshop, e questo contribuisce in maniera sostanziale all'usabilità pratica dello strumento.

Un ulteriore livello di complessità, per l'IA generativa, è il completamento credibile di oggetti, animali o persone parzialmente fuori quadro, come nell'esempio del gufo. In questi casi, l'IA dovrebbe non solo capire di cosa si tratta esattamente, ma anche "indovinare" la posa. Senza sorprese, questi sono anche i casi in cui il risultato appare più frequentemente artificiale. Aiuta, comunque, che vengano proposte tre varianti tra cui scegliere.

Originale

Variante A

Variante B

Come anticipato, è anche possibile chiedere all'IA di inserire oggetti non presenti nella scena originale, sostituire oggetti esistenti o cancellarne altri, ricreando un credibile sfondo (come già è possibile fare con le funzioni di riempimento sensibili al contesto).

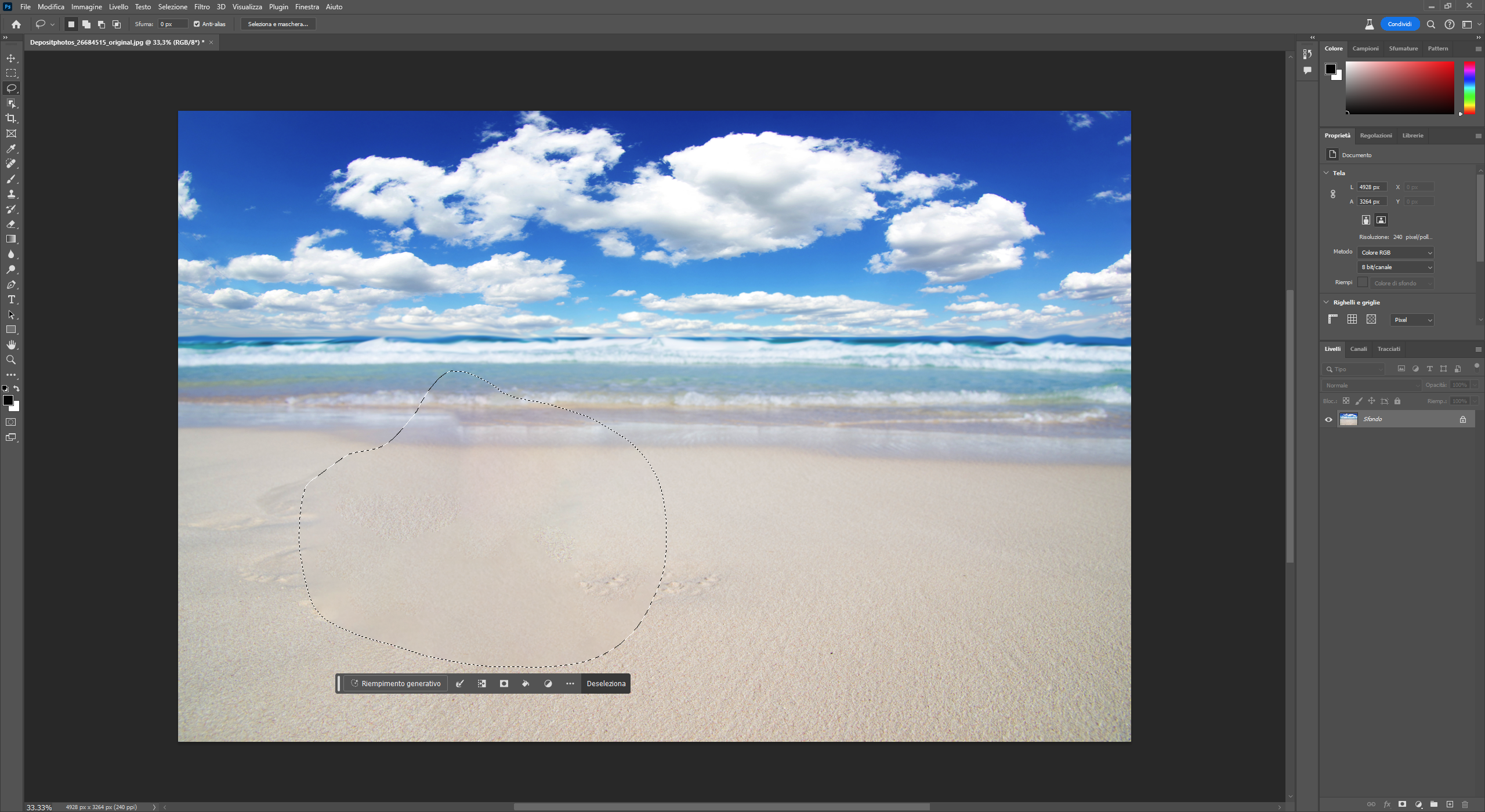

Lo strumento può essere ancora la Taglierina, nel caso di estensione della scena (basterà, come già detto, aggiungere un'opportuna descrizione testuale, ad esempio "nave da crociera all'orizzonte"), oppure è possibile utilizzare gli strumenti Selezione o Lazo, nelle diverse varianti (selezione rettangolare o ellittica, lazo semplice o poligonale…).

Il loro utilizzo è identico a quanto visto in precedenza: selezionando una parte di immagine, la barra degli strumenti contestuale attiva la funzione Riempimento generativo, analogo al precedente Espansione generativa. Anche in questo caso, è possibile scrivere una descrizione dell'oggetto da inserire o sostituire, oppure non scrivere nulla per generare uno sfondo compatibile con l'esistente, cioè "cancellare" il soggetto selezionato.

Le componenti create dall'IA provengono, o comunque attingono "per ispirazione" da Adobe Stock, e questo è anche il motivo per cui l'utilizzo di funzioni di IA generativa richiede una connessione a internet.

Nel corso della nostra prova, abbiamo ottenuto per inserimento e sostituzione dei risultati altalenanti, ma mediamente di livello inferiore a quanto ottenuto nel caso della generazione di contenuto senza inserimento di oggetti estranei, come del resto già osservato per l'Estensione generativa.

La variabilità è troppo alta per astrarre regole specifiche. Tutto dipende, e in modo sostanziale, dalla tipologia di contenuto in esame, nonché, verosimilmente, dalla presenza di quel contenuto in adobe Stock, ma possiamo mostrare alcuni esempi che dipingano il quadro generale.

Sopra: in evidenza l'estensione (a sinistra) e l'elemento da sostituire / rimuovere. Sotto: particolare dell'elemento sostituito / rimosso (ingrandimento 100%)

Originale

Rimozione

Sostituzione 1

Sostituzione 2

Come già accennato, la cancellazione di oggetti funziona mediamente molto bene, in effetti apprezzabilmente meglio del riempimento sensibile al contesto di precedente generazione. L'esempio della stella marina dice molto: grazie all'IA, non solo la sabbia ha una texture più realistica, ma anche la linea dell'onda sul bagnasciuga è regolare e indistinguibile dal vero, laddove il riempimento sensibile al contesto genera una discontinuità evidente.

Quando si vanno a inserire o sostituire alcuni elementi, viceversa, si può andare dal buon risultato al grottesco. Molto buono, ad esempio, il risultato delle barche a vela al polo nord, mentre la nave da crociera ha l'aspetto di un modellino giocattolo.

Originale

Variante A

Variante B

L'uomo in cima alla montagna, evidentemente già un fotomontaggio anche se in questo esempio rappresenta l'immagine di partenza, viene sostituito in modo piuttosto convincente dalle baite, anche se in questo caso l'ombra non viene gestita e rimane coerente con la figura umana. L'ombra viene invece gestita con l'inserimento del supereroe, in cui si nota la modifica del punto di partenza che, in questo caso, coincide con il piede del nuovo soggetto. Semmai, qui si può criticare la resa del supereroe in sé…

Originale

Variante A

Variante B

Variante C

Variante D

Il faro in controluce viene sostituito da altre strutture con risultati tutto sommato convincenti e, in alcuni casi, pesino con interessanti effetti di luce (sole parzialmente coperto, effetto flare). Quando, però, abbiamo chiesto all'IA di sostituire il terreno con un prato, il risultato è stato orribile.

Una cosa si può dire per certo: è necessario fare diversi tentativi e imparare a dialogare con l'IA, che richiede informazioni chiare e dettagliate. Un buon punto di partenza è immaginare di dialogare con un bambino, o un alieno alla prima visita sul pianeta Terra che, per questo, necessita che gli siano specificati anche particolari che nelle comuni conversazioni si danno per scontati.

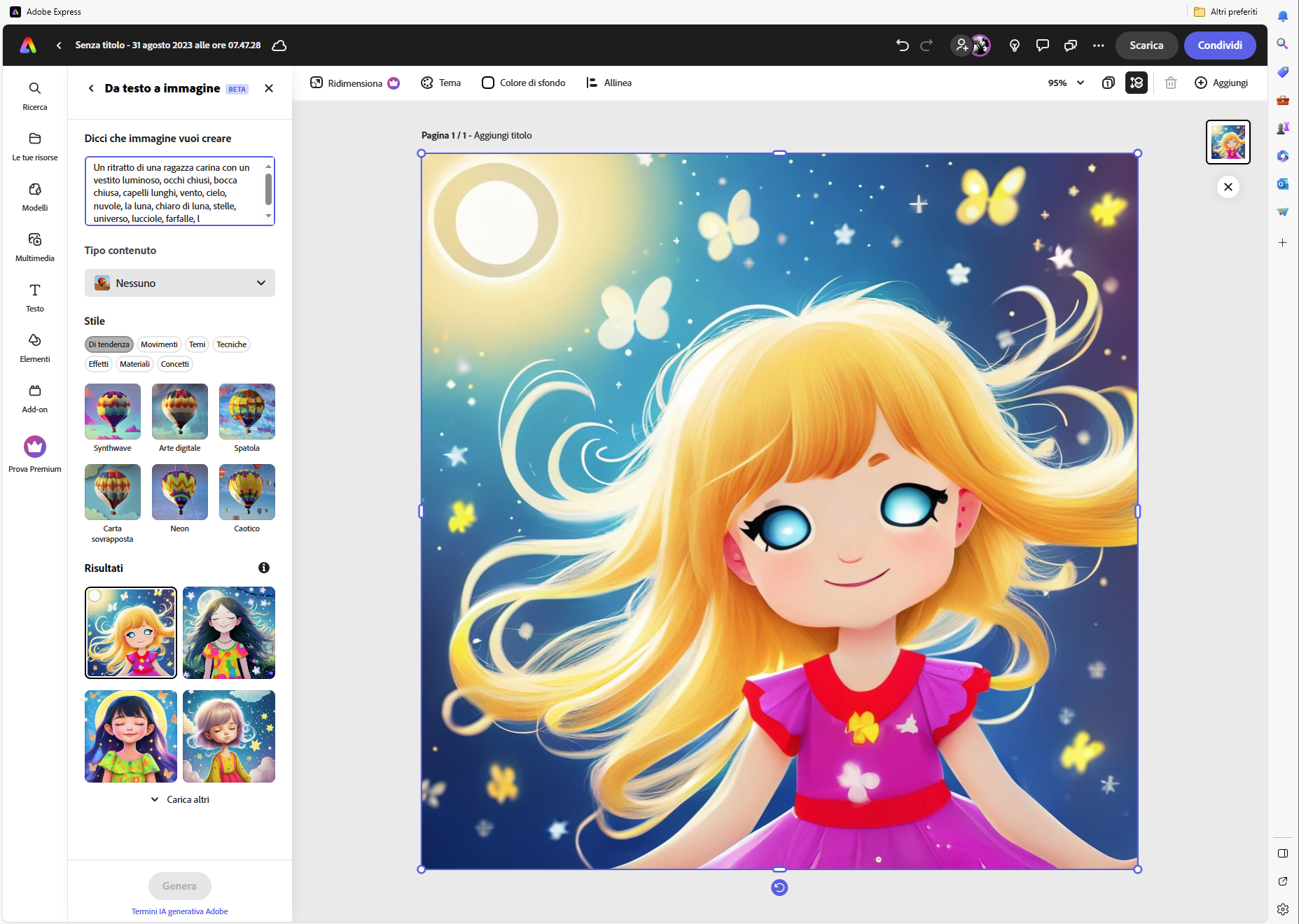

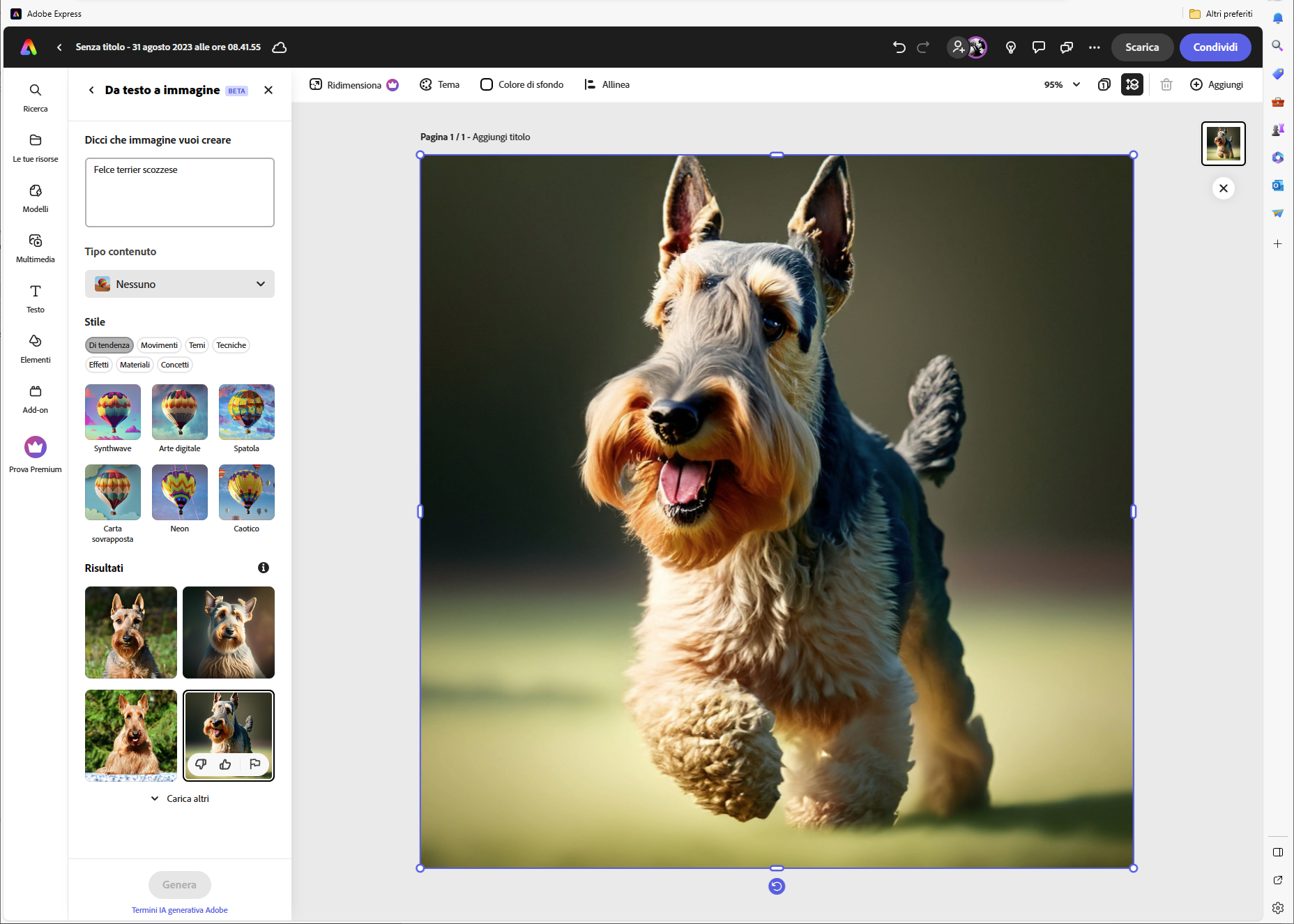

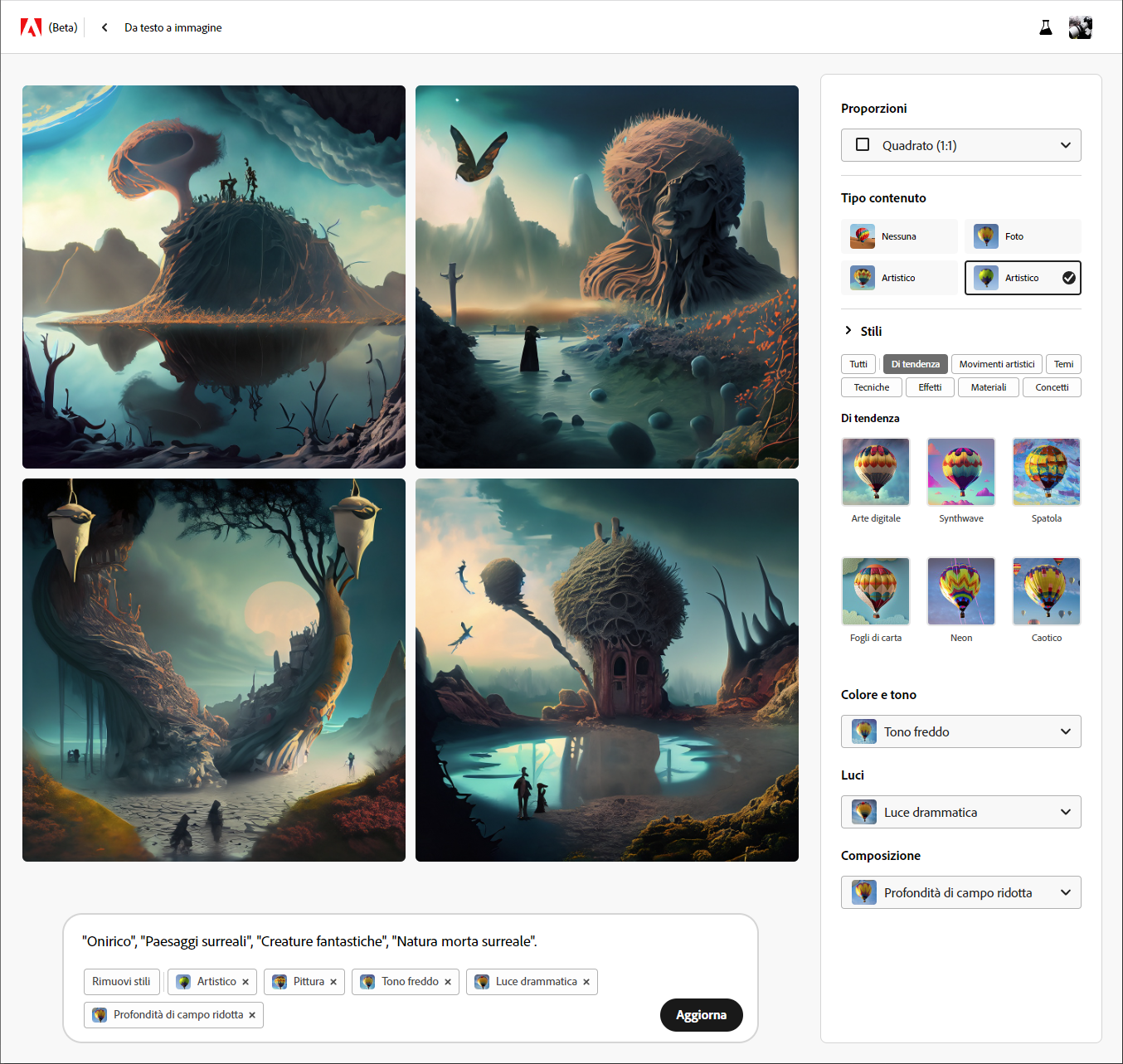

Questo è ancora più vero quando si passa dal "fotoritocco" di immagini reali alla creazione ex-novo di immagini completamente artificiali, come accade con la generazione Da testo a immagine, su cui diciamo solo poche battute. Innanzitutto, partendo dai link in apertura, Firefly e/o Adobe Express, si troveranno esempi di utilizzo che potranno dare degli spunti interessanti sul modo più efficace di fornire informazioni all'IA.

Premesso questo, e pur considerando questi strumenti ancora poco più che amatoriali, dobbiamo dire di aver apprezzato l'approccio Adobe, che è indubbiamente flessibile e orientato al risultato. Dell'immagine che si va a generare è infatti possibile definire il formato, la tipologia di contenuto (fotografico o artistico), lo stile (che arriva a definire, ad esempio nel caso di un dipinto, la tecnica di pittura – olio su tela o simili), colore e tono, tipologia di luce, composizione della scena (profondità di campo). In questo modo si ottiene un livello di controllo che lascia intravedere, in un futuro prossimo, sviluppi professionali anche di questo filone.

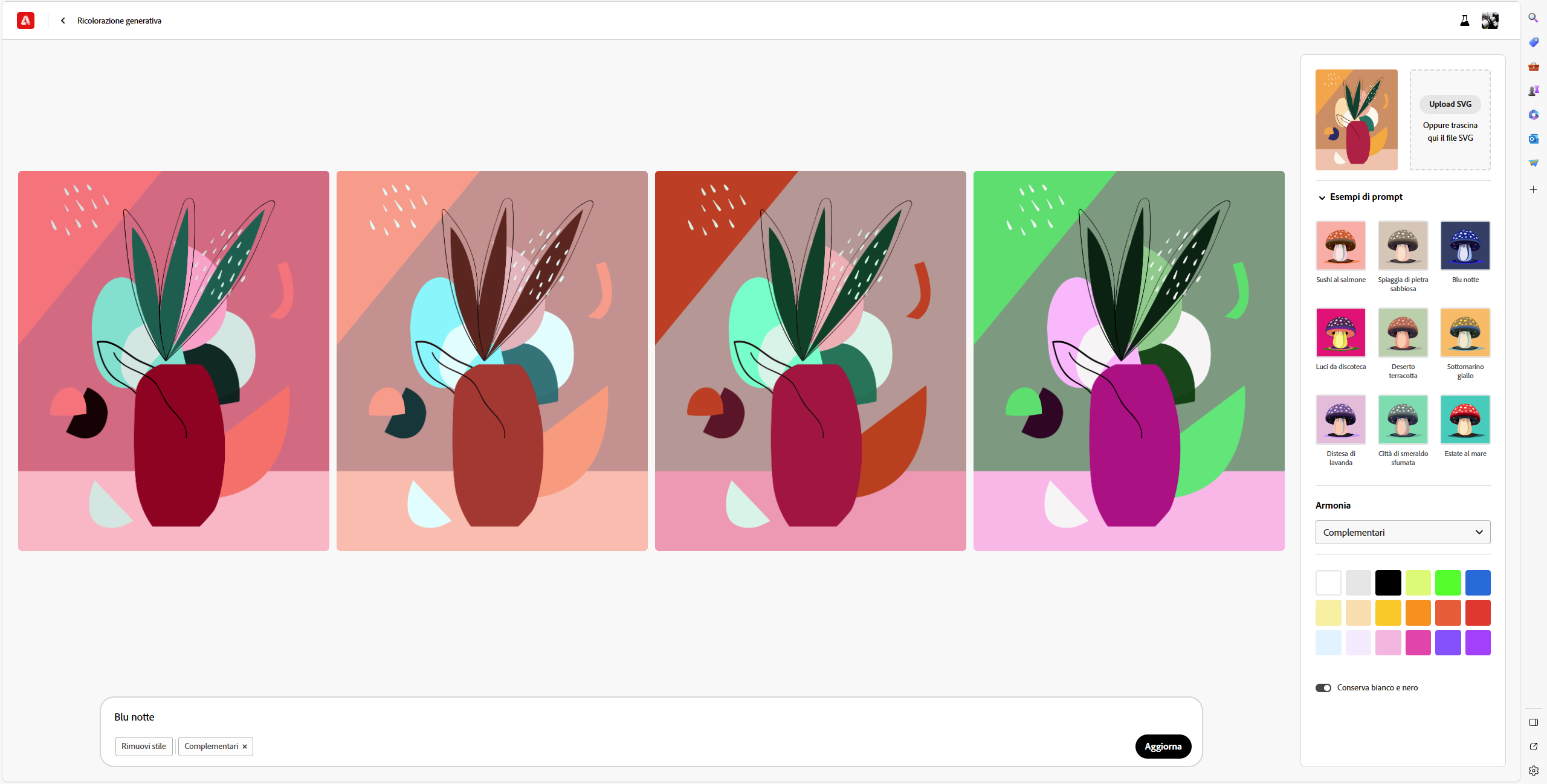

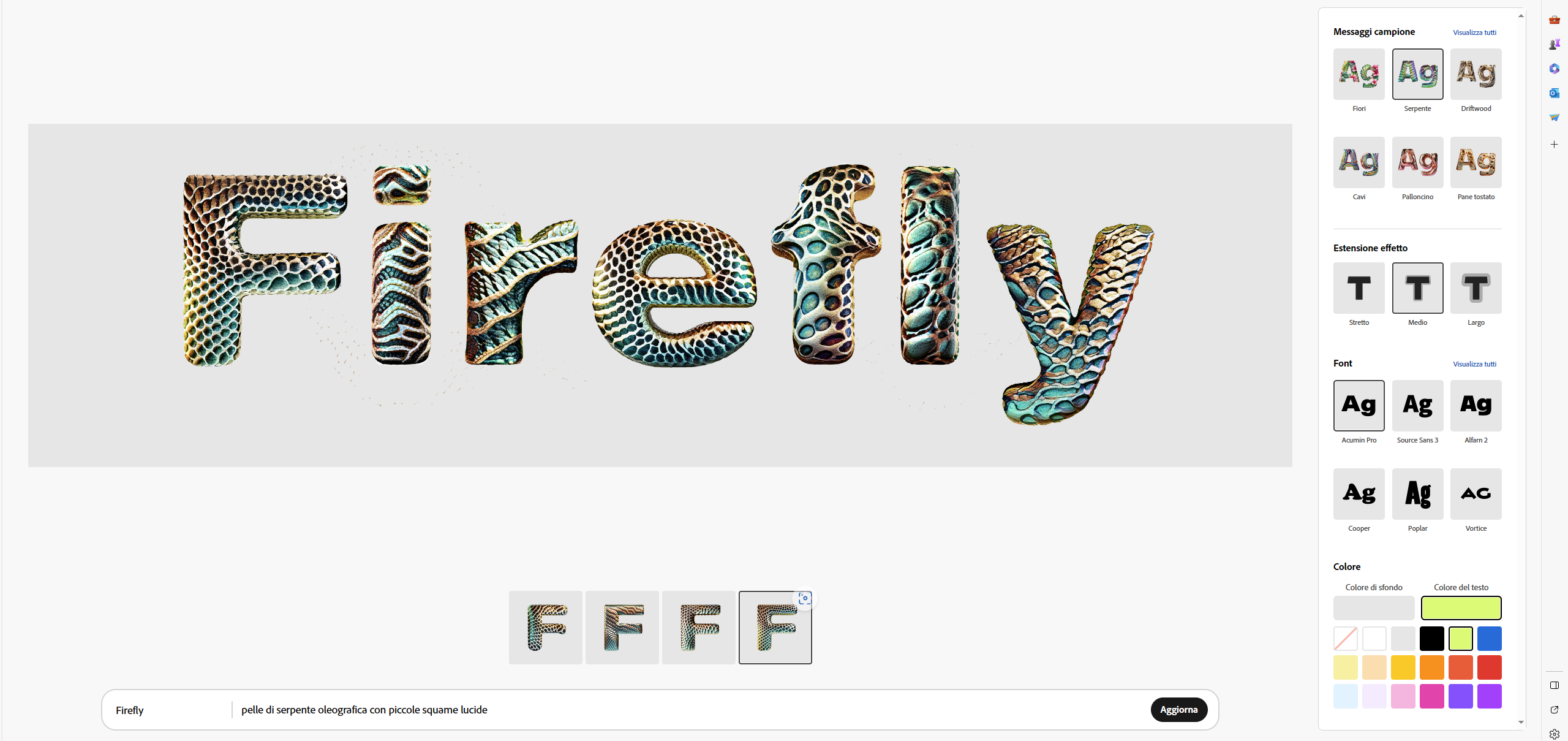

Non c'è molto da dire, infine, su Effetti di testo e Ricolorazione generativa, che svolgono il loro lavoro come ci si aspetta.